北京工業(yè)大學(xué) | 汽車輔助駕駛安全防撞預(yù)警系統(tǒng)

本項目依托于211高校計算智能與智能系統(tǒng)北京市重點實驗室,研發(fā)團隊包含工作人員(5名博士、4名碩士)以及6名研究生組成組成。本項目從2008年開始,經(jīng)過多年研究,具有充足的技術(shù)積累。成果屬于先進輔助駕駛(ADAS)技術(shù)的一部分,是應(yīng)用的熱點之一。目前市場上采用雷達較多,但成本高,基于圖像的系統(tǒng)較少。本成果利用安裝在汽車上的單目鏡頭采集視頻圖像,利用計算機視覺等技術(shù),開發(fā)了汽車安全防撞預(yù)警系統(tǒng),能自動實現(xiàn)車輛檢測、跟蹤與測距,給駕駛員提供安全防撞預(yù)警信息。本技術(shù)已經(jīng)完成前方車輛安全防撞預(yù)警算法、車道線檢測算法、車輛左右盲區(qū)安全防撞預(yù)警算法以及軟件的開發(fā),用采集的實際現(xiàn)場場景測試,效果良好。其核心技術(shù)均處于國內(nèi)先進水平,擁有自主知識產(chǎn)權(quán)。

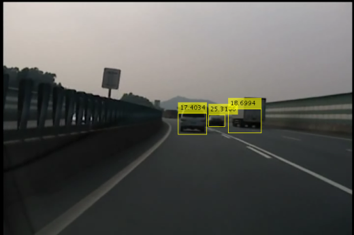

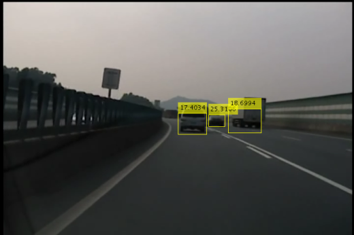

樣機(樣品)

成果簡介

本成果屬于先進輔助駕駛(ADAS)技術(shù)的一部分,目前是應(yīng)用的熱點之一。目前市場上采用雷達較多,但成本高,基于圖像的系統(tǒng)較少。

利用安裝在汽車上的單目鏡頭采集視頻圖像,利用計算機視覺等技術(shù),開發(fā)了汽車安全防撞預(yù)警系統(tǒng),能自動實現(xiàn)車輛檢測、跟蹤與測距,給駕駛員提供安全防撞預(yù)警信息。

該系統(tǒng)由攝像頭、車輛圖像處理算法和軟件、硬件處理模塊等部分組成,安裝在汽車上。

本系統(tǒng)可以實現(xiàn)對白天和夜間的前方車輛進行檢測、跟蹤與測距,也能增加對行車過程中車道線偏離進行檢測的模塊,可以用于車輛防撞預(yù)警。

車輛檢測具有較高的準確率和實時性,與采用雷達相比,實現(xiàn)成本低。

可以開發(fā)獨立的車輛防撞預(yù)警系統(tǒng),也可以在目前行車記錄儀基礎(chǔ)上增加車輛防撞預(yù)警功能模塊。

潛在應(yīng)用場景

1. 無人駕駛、輔助駕駛、新一代行車記錄儀系統(tǒng);

2. 機器人防撞障礙物探測感知、自主導(dǎo)航系統(tǒng);

3. 智能交通監(jiān)控系統(tǒng)(交通擁堵預(yù)警、事故跟蹤等);

4. 多媒體錄播跟蹤系統(tǒng);

......

技術(shù)優(yōu)勢

1. 單目鏡頭采集視頻圖像,成本低,可將防撞預(yù)警系統(tǒng)成本從萬元級降至千元級;

2. 能處理白天和黑夜多場景的車輛檢測、跟蹤與測距;

3.算法運算速度快、精度好、實時性高,系統(tǒng)準確率綜合達到94.1%,平均耗時僅28ms;

4.使用的標定方法簡單快速,適用于實際環(huán)境操作,技術(shù)在無人駕駛、輔助駕駛、新一代行車記錄儀等領(lǐng)域可進行市場化應(yīng)用。

專利號

軟件著作權(quán):2011SR087341,2015SR169389,2015SR021624,2016SR045698,2016SR045777,2018SR296952。

1.1 前方車輛安全防撞預(yù)警技術(shù)

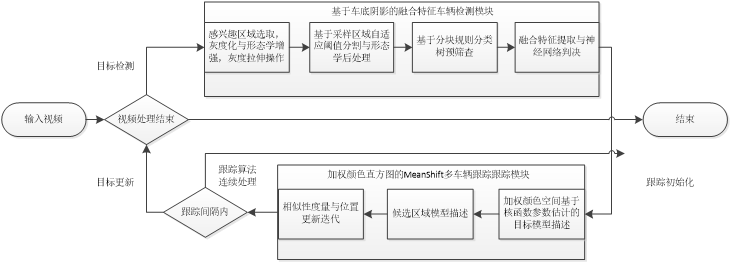

采用多特征融合的單目視覺車輛檢測與跟蹤新方法,具體內(nèi)容如下:

1. 圖像預(yù)處理與增強

根據(jù)前車出現(xiàn)區(qū)域及正常行駛場景構(gòu)圖等先驗知識,選定原始圖像縱向1/2以下為感興趣區(qū)域(Region of Interest, ROI)區(qū)域,可排除高空及復(fù)雜背景對后續(xù)算法影響,減輕計算負擔(dān)。

2. 特征提取及初步篩選

對分割后的陰影區(qū)域進行二值圖像連通分量特征提取,所選用的特征屬性包括:聯(lián)通分量區(qū)域像素總數(shù)、區(qū)域外接矩形、區(qū)域重心坐標、區(qū)域長軸長度、短軸長度、長軸短軸比率、方位角信息、緊致度信息。

3. 基于神經(jīng)網(wǎng)絡(luò)車輛檢測算法

傳統(tǒng)反向傳播神經(jīng)網(wǎng)絡(luò)學(xué)習(xí)算法是梯度下降法,利用誤差的一階微分信息,在訓(xùn)練過程中存在一些缺陷和不足;Levenberg-Marquardt神經(jīng)網(wǎng)絡(luò)學(xué)習(xí)算法利用二階微分信息進行網(wǎng)絡(luò)權(quán)值更新,收斂速度快,實用性好,廣泛應(yīng)用于最優(yōu)化算法,分類和識別神經(jīng)網(wǎng)絡(luò)的訓(xùn)練。

我們提出的車輛檢測算法在訓(xùn)練數(shù)據(jù)中準確率綜合達到94.1%。使用此算法能夠保證在中近距離內(nèi)實時,準確,低誤報的檢測車輛,對可能存在的碰撞隱患輸出告警信號。

4.基于加權(quán)顏色直方圖的Meanshift車輛跟蹤算法

基于Meanshift的多目標跟蹤算法依靠特征空間中的樣本點進行分析,不需先驗知識,收斂速度快,在圖像平滑,圖像濾波,圖像分割以及目標跟蹤等許多計算機視覺研究領(lǐng)域得到廣泛的關(guān)注和應(yīng)用。

采用經(jīng)典檢測-跟蹤-檢測框架進行視頻流圖像的連續(xù)處理,通過運行硬件平臺下算法時間效率及檢測算法,跟蹤算法穩(wěn)定性設(shè)定合理跟蹤幀長閾值,可成功處理車輛駛離前方預(yù)警區(qū)域及由于超車新加入預(yù)警區(qū)域情況下算對目標增減的情況。當(dāng)車輛檢測算法成功檢測前方車輛后,計算并描述跟蹤目標模板并進入后續(xù)跟蹤算法,跟蹤算法同時跟蹤前方多目標,循環(huán)往復(fù)直至處理完畢,處理流程如圖1所示,使用MeanShift跟蹤算法跟蹤前方檢測出的多目標車輛效果如圖:

1.2盲區(qū)車輛安全防撞預(yù)警算法

1.盲區(qū)車輛檢測算法

我們提出一種并行AdaBoost(Concurrent AdaBoost,CAdaBoost)算法并將其應(yīng)用到單目盲區(qū)車輛檢測中。與傳統(tǒng)AdaBoost相比,CAdaBoost在訓(xùn)練弱分類器時通過并行的方式選擇弱分類器,并在原有弱分類器系數(shù)的基礎(chǔ)上引入加權(quán)參數(shù),能夠更準確地描述被選擇的弱分類器在最終強分類中的作用。首先,確定ROI區(qū)域,即在的范圍進行車輪檢測,的范圍進行車頭檢測;其次,對ROI區(qū)域內(nèi)的車頭和車輪分別提取Haar-like特征;最后利用CAdBoost算法對盲區(qū)車輛進行檢測。通過與經(jīng)典的分類方法及多種AdaBoost分類器進行了

對比,結(jié)果表明ICAdaBoost取得更高的檢測率和更低的誤檢率,并獲得更短的訓(xùn)練時間,證明了該方法的有效性。具體步驟如下:

(1)提取Haar-Like特征

(2)基于改進AdaBoost算法的盲區(qū)車輛檢測

(3)盲區(qū)車輛檢測結(jié)果后處理融合

我們提出的基于ICAdaBoost盲區(qū)車輛檢測算法不僅獲得了97.93%最高檢測正確率,而且在單幀的盲區(qū)車輛檢測中時間最短,能夠很好的滿足實時性的需求。

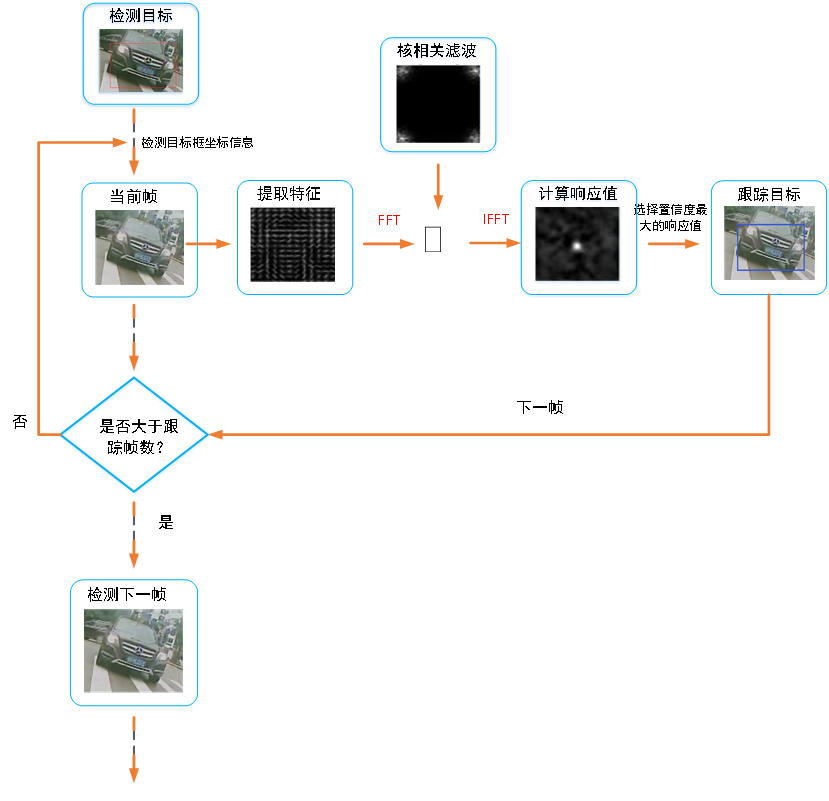

2.盲區(qū)跟蹤算法

采用KCF跟蹤算法,主要解決尋找在空間域上嶺回歸問題的最優(yōu)濾波器的問題,通過學(xué)習(xí)核化的正則化最小二乘線性分類器對目標進行。KCF跟蹤算法的核心思想是:通過引入密集采樣的概念,利用循環(huán)移位得到循環(huán)矩陣;然后運用高斯核函數(shù)計算分類器與新一幀圖像候選區(qū)域的相關(guān)系數(shù),最大相關(guān)系數(shù)的點即更新的目標位置。根據(jù)循環(huán)卷積定理,所有與循環(huán)矩陣的點積運算都可以轉(zhuǎn)化為與該矩陣第一行向量的卷積運算,計算速度得到很大提升。

3.盲區(qū)車輛測距算法

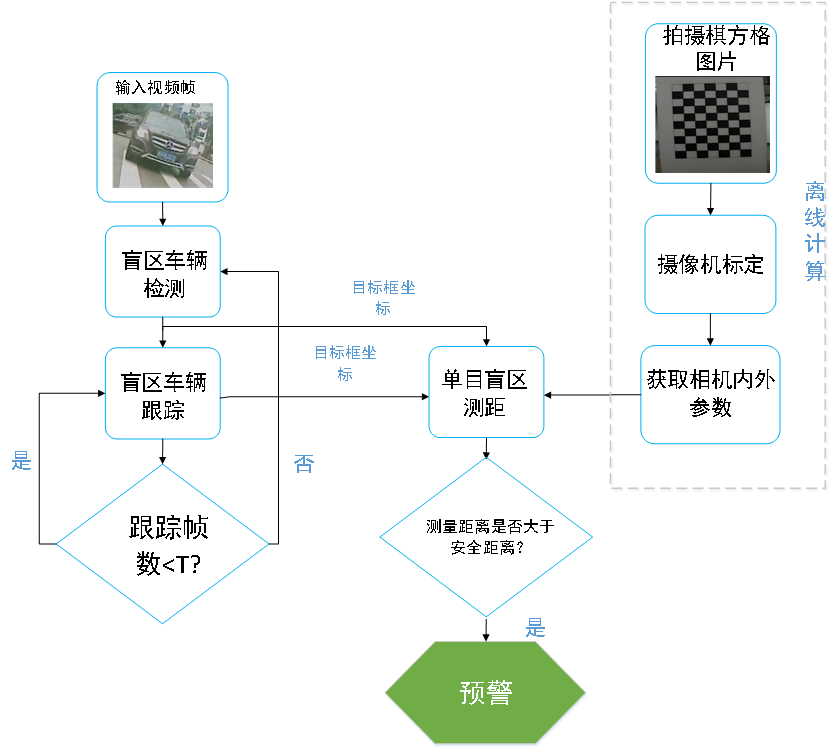

采用基于小孔成像測距模型的單目盲區(qū)車輛測距方法,測出距離之后與預(yù)警安全距離進行比較,如果小于閾值則進行預(yù)警提醒,進而輔助駕駛員安全行駛。預(yù)警流程如圖:

其它方面

還開發(fā)了與車載先進輔助駕駛相關(guān)的如下技術(shù):

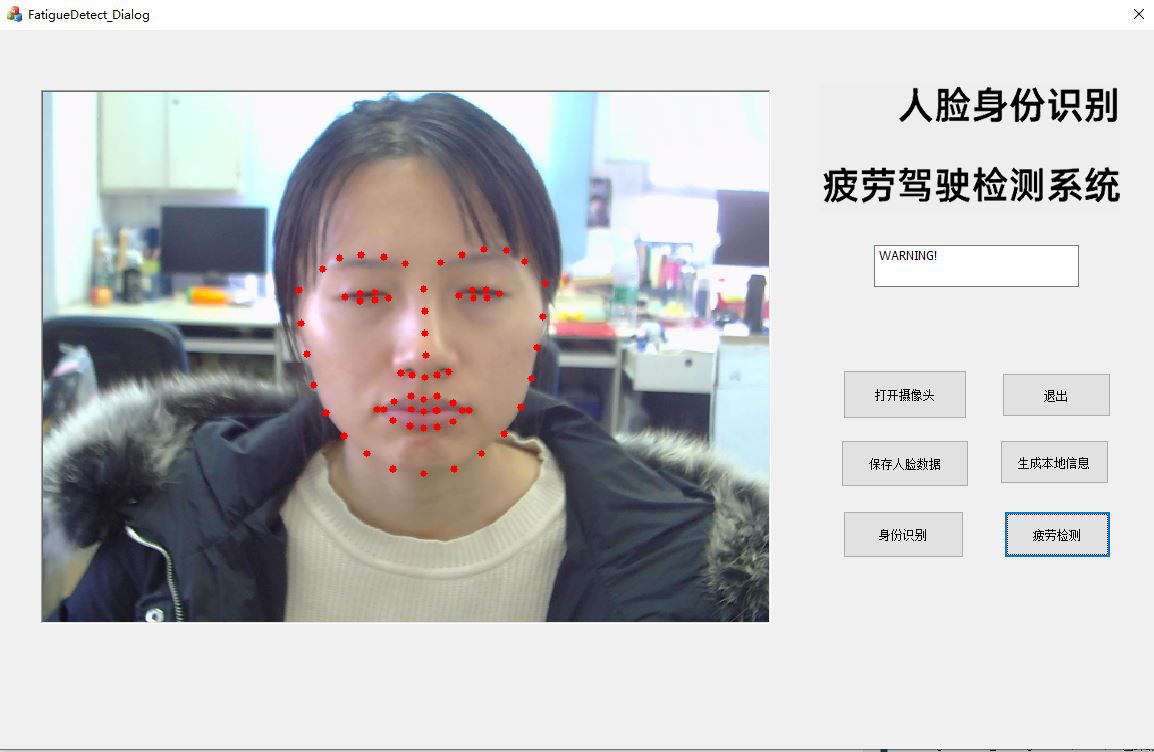

司機的疲勞駕駛檢測與人臉識別:

交通標志識別技術(shù)

打開微信

“掃一掃”